Modèle de raisonnement QwQ-32B

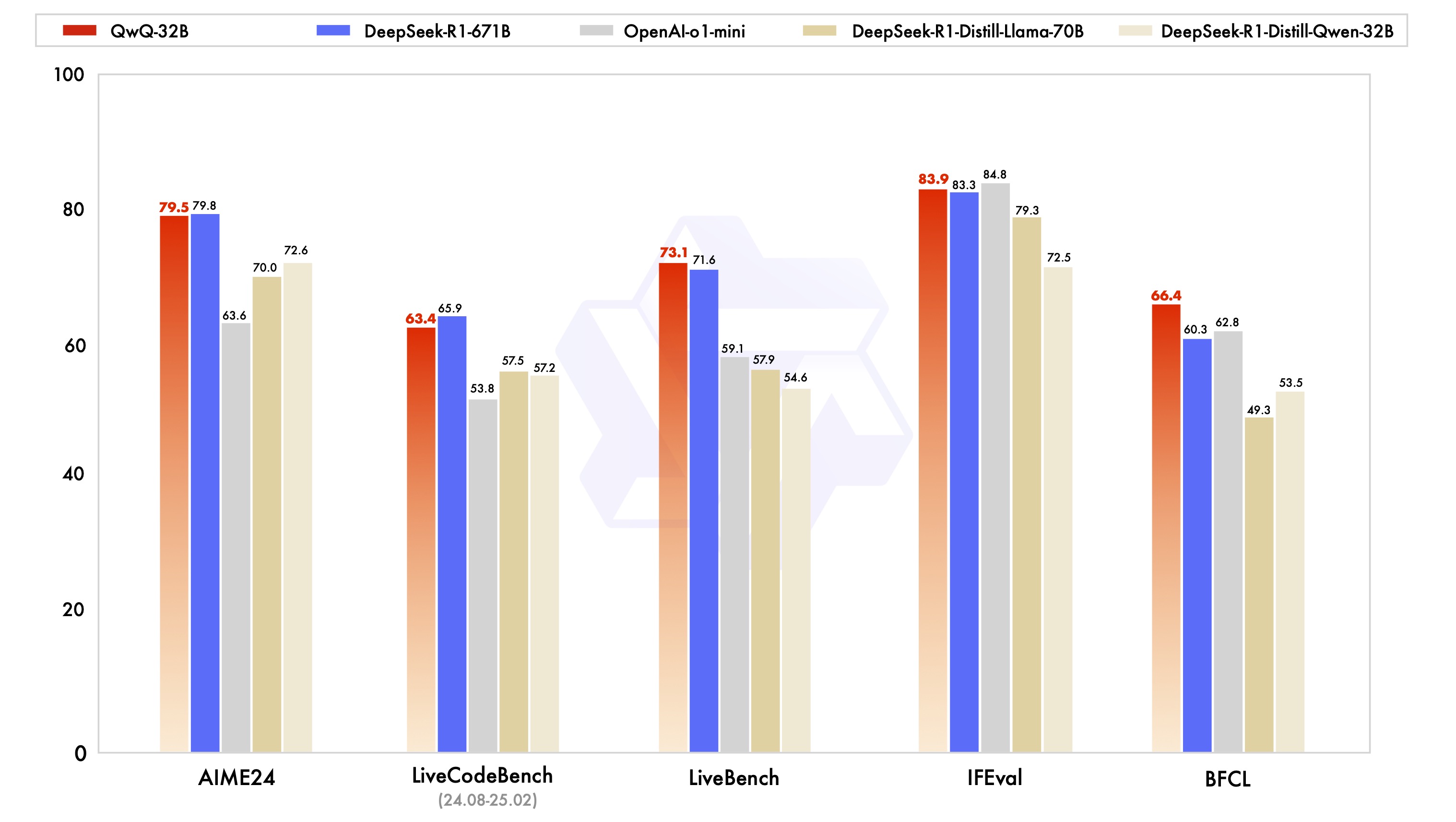

Un puissant modèle de raisonnement de la série Qwen, capable de penser et de raisonner avec des performances significativement améliorées dans les tâches en aval, en particulier les problèmes difficiles. QwQ-32B atteint des performances compétitives par rapport aux modèles de raisonnement de pointe.

Caractéristiques clés :

- Architecture avancée avec RoPE, SwiGLU, RMSNorm

- 32,5 milliards de paramètres (31,0 milliards non-embedding)

- Longueur de contexte de 131 072 tokens

- Capacités de raisonnement à la pointe

Essayez QwQ-32B

Testez notre modèle via HuggingFace Spaces ou QwenChat - sans installation nécessaire.

Fonctionnalités

Ce qui rend QwQ-32B spécial

QwQ-32B est un modèle de raisonnement de taille moyenne qui combine de puissantes capacités de réflexion avec des performances de pointe.

Architecture avancée

Construit avec des transformers intégrant RoPE, SwiGLU, RMSNorm et biais d'attention QKV

Structure sophistiquée

64 couches avec 40 têtes d'attention pour Q et 8 pour KV (GQA)

Longueur de contexte étendue

Prend en charge une longueur de contexte complète de 131 072 tokens pour une analyse approfondie

Grande échelle de paramètres

32,5 milliards de paramètres totaux avec 31,0 milliards de paramètres non-embedding pour un raisonnement profond

Raisonnement amélioré

Performances significativement améliorées sur les tâches en aval et les problèmes difficiles

Déploiement facile

Prend en charge diverses options de déploiement, y compris vLLM pour des performances optimales

Ce que les gens en disent

Retours de la communauté sur QwQ-32B

Today, we release QwQ-32B, our new reasoning model with only 32 billion parameters that rivals cutting-edge reasoning model, e.g., DeepSeek-R1.

— Qwen (@Alibaba_Qwen) March 5, 2025

Blog: https://t.co/zCgACNdodj

HF: https://t.co/pfjZygOiyQ

ModelScope: https://t.co/hcfOD8wSLa

Demo: https://t.co/DxWPzAg6g8

Qwen Chat:… pic.twitter.com/kfvbNgNucW

The new QwQ-32B by Alibaba scores 59% on GPQA Diamond for scientific reasoning and 86% on AIME 2024 for math. It excels in math but lags in scientific reasoning compared to top models. pic.twitter.com/MLcKsumk4n

— xNomad (@xNomadAI) March 7, 2025

the new QwQ 32B model is insanely fast…

— David Ondrej (@DavidOndrej1) March 6, 2025

imagine once this is added to Infinite Thinking 😮💨 pic.twitter.com/z0kftcV8zW

الصين 🇨🇳 ما زالت تتحدى

— سعيد الكلباني (@smalkalbani) March 5, 2025

أطلقت Alibaba نموذج صغير QwQ-32B ولكنه يتفوق على DeepSeek الذي يفوقه في الحجم بحوالي 20 مرة.

QwQ-32B يتفوق على جميع النماذج مفتوحة المصدر ولكنه يتخلف بفارق بسيط عن o1

بالامكان استخدامه من هنا https://t.co/ySOcPP3uFb pic.twitter.com/Y3M5kjjr4v

QwQ-32B changed local AI coding forever 🤯

— Victor M (@victormustar) March 7, 2025

We now have SOTA performance at home. Sharing my stack + tips ⬇️ pic.twitter.com/dL3pkCfdm5

QwQ-32B 的 KCORES 大模型竞技场测试结果发布!

— karminski-牙医 (@karminski3) March 6, 2025

Qwen-QwQ-32B-BF16 目前测试得分为 278.9 分(图1),在榜单中超过了 DeepSeek-V3, 距离DeepSeek-R1 还比较远。

但是!距离线上的 Qwen-2.5-Max-Thinking-QwQ-Preview 仅差 0.2 分!这意味着千问这次开源的的确就是线上水平的版本!(性能类似… pic.twitter.com/ifNGKt312a

今週のAI界隈、激動すぎる...

— すぐる | ChatGPTガチ勢 𝕏 (@SuguruKun_ai) March 10, 2025

・Windsurf Previewsでアプリ開発が進化

・ChatGPTがIDEコード編集に対応

・Sesameが超リアルなAI音声を実現

・Alibaba QwQ-32Bが小型で高性能な推論

・Mistral OCRがドキュメント理解API発表

・Deepseekの再来・AIエージェントmanus

詳細スレッドで解説します👇🧵

【DeepSeek超え】中国からまた半端ないAIモデルが登場

— チャエン | デジライズ CEO《重要AIニュースを毎日最速で発信⚡️》 (@masahirochaen) March 6, 2025

アリババのAIモデル「QwQ-32B」が公開。

なんとパラメーター32BでDeepSeek R1 671Bを超えの精度。実はQWENのチャットは無料で深い思考、ウェブ検索、Artifacts、動画・画像生成が可能で実は最強。こんな高機能で無料は唯一無二。⇩リンク pic.twitter.com/kbDCbQgzlT